LongCat-Flash-Omni 正式发布并开源:开启全模态实时交互时代

一、家族新成员登场:LongCat 系列的全模态进化

自 9 月 1 日美团重磅推出 LongCat-Flash 系列模型以来,开源的 LongCat-Flash-Chat 与 LongCat-Flash-Thinking 凭借高效架构与实用能力迅速俘获开发者群体。如今,这一备受瞩目的模型家族迎来关键升级 ——LongCat-Flash-Omni 正式发布并开源,标志着美团在全模态 AI 领域完成从 “专项突破” 到 “综合引领” 的重要跨越,为行业注入实时交互新动能。

作为系列首款全模态旗舰模型,LongCat-Flash-Omni 并非简单叠加模态能力,而是在继承家族基因基础上实现架构创新。其核心突破在于解决了行业长期存在的 “大参数与低延迟” 矛盾:在总参数达 5600 亿、激活参数 270 亿的规模下,仍能实现毫秒级音视频交互响应,彻底打破全模态应用的性能瓶颈。

二、全模态能力实测:开源领域的 SOTA 级表现

综合多维度基准测试显示,LongCat-Flash-Omni 不仅实现了文本、图像、音频、视频的全模态覆盖,更在各细分领域达到开源顶尖水平,部分指标可与闭源旗舰模型直接对标。

(一)单模态能力:多点突破,比肩旗舰

文本能力:延续系列优势并实现性能升级,在指令跟随、长上下文推理等任务中表现优异,印证了多模态融合对基础能力的正向增益。

图像理解:在 RealWorldQA 基准测试中取得 74.8 分的成绩,与闭源模型 Gemini-2.5-Pro 持平,显著优于 Qwen3-Omni 等开源同类模型,尤其在多图像关联任务中优势突出。

音频处理:实现 “识别 - 生成 - 理解” 全链路领先,自动语音识别(ASR)在 LibriSpeech、AISHELL-1 数据集表现超越 Gemini-2.5-Pro,语音到文本翻译(S2TT)在 CoVost2 任务中性能强劲,音频理解任务更是刷新当前最优纪录。

视频解析:通过动态帧采样与分层令牌聚合技术,在短视频理解任务中大幅领先现有模型,长视频处理能力可与 Gemini-2.5-Pro、Qwen3-VL 等顶尖模型比肩。

(二)跨模态与交互:实用场景的核心优势

在更贴近实际应用的跨模态任务中,LongCat-Flash-Omni 展现出高效的融合能力:在真实世界音视频理解基准 WorldSense 中,相较其他开源模型取得显著优势,跨模态推理性能比肩 Gemini-2.5-Pro(非思考模式)。

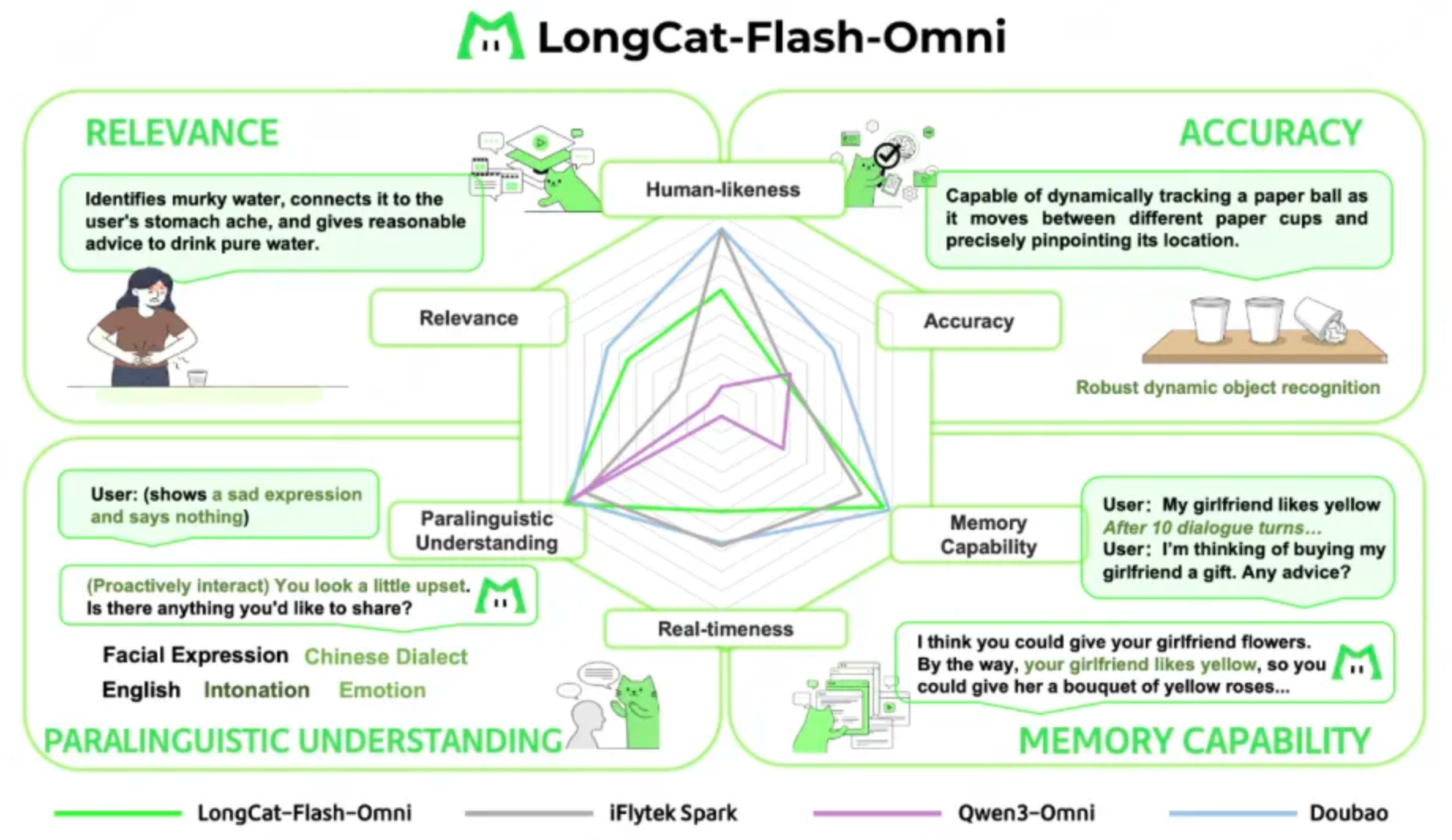

针对实时交互场景,美团技术团队构建了包含 250 名用户评分与 10 名专家分析的专属评测体系。结果显示,其交互自然度与流畅度评分比当前最优开源模型 Qwen3-Omni 高出 0.56 分,在副语言理解、对话相关性与记忆能力三个维度已达到顶级模型水平,类人性指标甚至优于 GPT-4o,完全满足实时应用需求。

三、技术内核解密:高效架构的创新设计

LongCat-Flash-Omni 的性能突破源于底层架构的系统性优化,三大核心技术共同支撑起 “大参数、全模态、低延迟” 的综合优势。

(一)基础架构:Shortcut-Connected MoE 的效率基因

继承自系列的 Shortcut-Connected MoE 架构是实现效率突破的核心基础。该架构通过 “零计算专家” 设计与动态路由机制,让模型仅激活必要参数进行计算,在保证性能的同时大幅降低推理开销。这种动态计算特性使模型能根据任务复杂度自适应调整资源占用,为多模态交互的低延迟提供了架构保障。

(二)模态融合:感知与重建模块的创新集成

模型创新性地集成了高效多模态感知模块与语音重建模块,实现了不同模态数据的端到端处理。与传统 “模态拼接” 方案不同,其融合机制贯穿训练与推理全流程,通过跨模态注意力机制实现信息深度交互,既保证了各模态能力的独立性,又强化了协同效应,这也是其文本能力未因多模态集成而衰减的关键原因。

(三)工程优化:推理效率的极致打磨

依托美团在 AI 工程化领域的深厚积累,模型采用了多项针对性优化技术:借鉴系列成熟的量化加速方案,通过 ULP 评估筛选低误差算子,在保证精度的前提下降低计算负载;同时引入 SDC 检测机制,对 FlashAttention Gradients 进行片上重计算,确保大规模并行推理的数据可靠性。这些优化措施共同实现了 “5600 亿参数 + 毫秒级响应” 的行业奇迹。

四、开源生态与应用:开发者的全模态工具箱

作为业界首个集 “全模态覆盖、端到端架构、大参数量高效推理” 于一体的开源大语言模型,LongCat-Flash-Omni 为开发者提供了前所未有的技术自由度与落地可能性。

(一)开源支持:低门槛部署与商业友好

模型已在 GitHub、Hugging Face 平台同步开源(仓库地址:https://github.com/meituan-longcat/LongCat-Flash-Chat),并采用 MIT 许可协议,允许开发者进行二次训练、模型蒸馏及商业应用。官方同步提供基于 SGLang 与 vLLM 的两种高效部署方案,开发者可通过简单指令完成单机部署,例如基于 SGLang 的部署命令仅需配置模型路径与并行参数即可启动:

python3 -m sglang.launch_server --model meituan-longcat/LongCat-Flash-Chat-FP8 --trust-remote-code --attention-backend flashinfer --enable-ep-moe --tp 8

(二)典型应用场景:从企业级到开发者工具

结合模型特性与美团业务实践,其应用潜力已在三大领域得到验证:

智能交互终端:依托实时音视频处理能力,可构建新一代智能客服系统,实现 “语音咨询 - 图像识别 - 视频指导” 的全流程服务,例如餐饮场景中通过图像识别菜品并生成推荐,同时响应语音咨询。

企业业务自动化:在物流、零售等场景中,可融合多模态数据完成复杂任务,如通过视频监控分析门店客流、结合语音指令生成库存调度方案,或像系列前代模型一样处理包含 30 个工具的复杂工具链协同任务。

开发者工具链:为多模态应用开发提供高效底座,支持从代码生成到跨模态测试的全流程辅助,例如根据设计图(图像)生成前端代码、通过语音指令调试视频处理脚本等。

五、行业意义:开源生态的全模态新起点

LongCat-Flash-Omni 的发布不仅是美团技术实力的展示,更对整个 AI 行业具有标志性意义。它首次在开源范畴内实现了全模态能力对闭源模型的对标,打破了 “优质全模态技术仅掌握在少数巨头手中” 的格局,为中小企业与开发者提供了低成本使用顶尖技术的可能。

从技术演进视角看,其 “大参数高效推理” 的架构设计为行业提供了可复用的优化范式,所解决的延迟痛点将加速全模态技术在直播互动、智能硬件、远程协作等实时场景的落地。正如美团技术团队在技术报告中强调的,动态计算与模态融合的结合,将是下一代 AI 模型的核心发展方向。

目前,开发者可通过官方网站(https://longcat.ai/)直接体验模型能力,或通过开源仓库获取部署资源。随着生态的不断完善,LongCat-Flash-Omni 有望成为全模态应用开发的 “基础设施级” 模型,推动 AI 交互进入更自然、更实时的新时代。

-

Sora AI 重磅更新:宠物分身功能开放,安卓版开启预注册,OpenAI 引爆视频创作新热潮

2025-10-28

2025-10-28 129

129 -

凌晨重磅:谷歌最强 AI 模型 Gemini 3 正式亮相,多模态能力再破天花板

2025-11-19

2025-11-19 179

179 -

会 “头脑风暴” 的 AI 来了!国内首个并行思考模型问小白 o4 上线,8 条路径同步推理找最优解

2025-08-26

2025-08-26 169

169 -

马斯克携 Grokipedia 宣战维基百科:AI 驱动的知识平台能否重塑信息格局?

2025-10-01

2025-10-01 91

91 -

阿里巴巴瓴羊发布首个数据分析 Agent:智能小 Q 升级超级 AI 分析师

2025-08-30

2025-08-30 264

264 -

Gaga – AI视频生成平台,专注生成影视级人物表演

2025-10-12

2025-10-12 94

94 -

美团 LongCat-Flash-Chat 开源:560B 参数 MoE 模型引领高效 AI,100+tokens/s 推理 + 5 元 / 百万 token 低成本落地

2025-09-01

2025-09-01 219

219 -

生成引擎优化(GEO):AI时代企业的流量新密码

2025-08-19

2025-08-19 120

120 -

30秒做应用、实时写图文,「灵光」想用AI重塑创造力边界

2025-11-18

2025-11-18 98

98 -

LongCat-Flash-Omni 正式发布并开源:开启全模态实时交互时代

2025-11-03

2025-11-03 64

64

咨询热线:

咨询热线:

联系电话

联系电话 联系邮箱

联系邮箱 联系QQ

联系QQ 方案获取

方案获取